Datenanalyse-Tools

Einführung

In der heutigen schnelllebigen, datengesteuerten Geschäftswelt sammeln und speichern Organisationen enorme Mengen an Daten. Große Datenmengen sind wichtige Informationen, die Unternehmen helfen, bessere Entscheidungen zu treffen, Abläufe zu verbessern und der Konkurrenz voraus zu bleiben. Um jedoch den vollen Wert dieser riesigen Datenmengen freizusetzen, benötigen Organisationen leistungsstarke Datenanalyse-Tools und -Lösungen.

Dieser Artikel erklärt die Grundlagen von Datenanalyse-Tools, einschließlich Big Data, beliebter Analysetools und Open-Source-Lösungen. Wir werden die Vorteile der Verwendung dieser Tools untersuchen und Ihnen helfen, die beste Lösung für Ihr Unternehmen auszuwählen. Sie werden verstehen, wie diese Tools Ihrem Unternehmen helfen können, Daten zu nutzen, um erfolgreich zu sein.

Was ist Big Data?

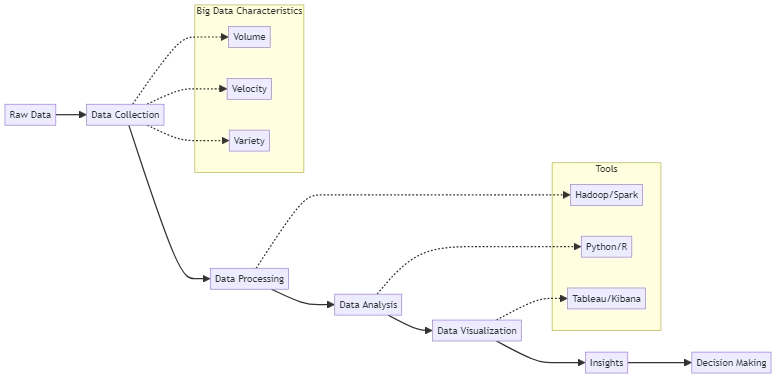

Organisationen sammeln eine beträchtliche Menge an Daten, die als Big Data bekannt sind, aus Quellen wie sozialen Medien, Sensoren und Transaktionssystemen. Diese Daten sind oft zu groß und komplex für traditionelle Datenverarbeitungstools. Die drei Hauptmerkmale von groß angelegten Daten sind:

- Volumen: Die schiere Menge der gesammelten und gespeicherten Daten.

- Geschwindigkeit: Die Geschwindigkeit der Datenproduktion und -verarbeitung.

- Vielfalt: Die verschiedenen Arten von Daten, einschließlich strukturierter, semistrukturierter und unstrukturierter Daten.

Organisationen benötigen fortschrittliche Datenanalyse-Tools, um den Wert aus großen Datenmengen zu extrahieren. Diese Tools helfen dabei, große Informationsmengen schnell und effizient zu verarbeiten und zu analysieren. Sie helfen Unternehmen, Muster und Trends in ihren Daten zu finden und geben wichtige Einblicke für strategische Entscheidungen.

Die Bedeutung von Big Data Analytics

Big Data Analytics ist für Organisationen in verschiedenen Branchen immer entscheidender geworden. Durch die Nutzung der Macht der Daten können Unternehmen:

- Kundenverständnis verbessern: Analysieren Sie das Verhalten, die Vorlieben und das Feedback der Kunden, um gezielte Marketingstrategien und personalisierte Erlebnisse zu entwickeln.

- Betriebsabläufe optimieren: Identifizieren Sie Ineffizienzen, verbessern Sie Prozesse und reduzieren Sie Kosten, indem Sie Betriebsdaten analysieren.

- Risikomanagement verbessern: Betrug erkennen und verhindern, die Einhaltung von Vorschriften überwachen und Risiken mindern, indem Sie Finanz- und Transaktionsdaten analysieren.

- Innovation vorantreiben: Bleiben Sie der Konkurrenz voraus, indem Sie Markttrends und Kundenbedürfnisse untersuchen. Nutzen Sie diese Informationen, um neue Chancen zu finden und neue Produkte und Dienstleistungen zu schaffen.

Da die Datenmengen und ihre Komplexität zunehmen, wird die Nutzung fortschrittlicher Datenanalyse-Tools immer wichtiger. Organisationen müssen in die richtigen Tools und Lösungen investieren, um mit diesem Trend Schritt zu halten.

Datenanalysetools

Datenanalysetools sind Softwareanwendungen, die Organisationen dabei helfen, ihre Daten zu verarbeiten, zu visualisieren und zu interpretieren. Diese Tools können von einfachen Tabellenkalkulationsanwendungen bis hin zu komplexen, unternehmensweiten Lösungen reichen. Einige beliebte Datenanalysetools sind:

- Microsoft Excel: Excel ist ein weit verbreitetes Programm zum Erstellen von Pivot-Tabellen und Diagrammen für die Datenanalyse. Geeignet für kleine Datensätze und grundlegende Analysen, kann jedoch bei größeren, komplexeren Datensätzen Schwierigkeiten haben. Zum Beispiel, um in Excel eine Pivot-Tabelle zu erstellen, wählen Sie einfach Ihre Daten aus, gehen Sie zum “Einfügen”-Tab und klicken Sie auf “PivotTable”.

- Tableau: Tableau ist einfach zu bedienen, um interaktive Dashboards und Berichte zu erstellen, ohne Programmierkenntnisse zu benötigen. Es verbindet sich mit verschiedenen Datenquellen und erleichtert den Benutzern die Erkundung und Analyse ihrer Daten.

- Python: Python ist eine gängige Programmiersprache zur Datenanalyse. Es verfügt über Bibliotheken wie NumPy, Pandas und Matplotlib, die bei der Datenmanipulation, der statistischen Analyse und bei maschinellen Lernprojekten helfen. Beispiel:

- R: Eine statistische Programmiersprache, die in der Wissenschaft und Industrie weit verbreitet ist zur Datenanalyse und maschinellem Lernen. R bietet eine breite Palette an Paketen für die Datenmanipulation, Visualisierung und statistische Modellierung. Beispiel:

- Apache Spark: Ein Open-Source, verteiltes Rechensystem, das große Datensätze über Computercluster hinweg verarbeiten kann. Spark bietet APIs in Java, Scala, Python und R und ist somit für eine breite Benutzergruppe zugänglich. Beispiel: Um Spark zur Datenverarbeitung zu verwenden, müssen Sie ein Spark-Cluster einrichten und Code mit einer der unterstützten APIs schreiben. Hier ist ein einfaches Beispiel mit PySpark:

import pandas as pd

data = pd.read_csv('sales_data.csv')

total_sales = data['revenue'].sum()

print(f"Total sales: ${total_sales:.2f}")Dieser Python-Code verwendet die Pandas-Bibliothek, um eine CSV-Datei mit Verkaufsdaten zu lesen, den Gesamterlös zu berechnen und das Ergebnis auszugeben.

library(ggplot2)

data <- read.csv("sales_data.csv")

ggplot(data, aes(x = product, y = revenue)) +

geom_bar(stat = "identity", fill = "steelblue") +

labs(title = "Sales by Product", x = "Product", y = "Revenue")Dieser R-Code verwendet das ggplot2-Paket, um ein Balkendiagramm zu erstellen, das die Umsatzerlöse nach Produkt visualisiert.

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("SalesAnalysis").getOrCreate()

data = spark.read.csv("sales_data.csv", header=True, inferSchema=True)

total_sales = data.agg({"revenue": "sum"}).collect()[0][0]

print(f"Total sales: ${total_sales:.2f}")Dieser PySpark-Code liest eine CSV-Datei, berechnet die Gesamteinnahmen und druckt das Ergebnis aus.

Diese Tools können grundlegende Aufgaben ausführen, wie das Erkunden von Daten und das Erstellen von Diagrammen. Sie können auch fortgeschritte Aufgaben bewältigen, wie die statistische Analyse und das Nutzen von maschinellem Lernen. Durch die Verwendung dieser Tools können Organisationen ihre Daten besser verstehen und intelligentere Entscheidungen treffen.

Open-Source-Datenanalyse-Lösungen

Es gibt kostenlose Open-Source-Datenanalysetools, die leistungsstarke Funktionen bieten, zusätzlich zu kommerziellen Optionen. Einige beliebte Open-Source-Datenanalysetools sind:

- Apache Hadoop: Ein System, das große Datenmengen über mehrere Gruppen einfacher Hardware speichert und verarbeitet. Hadoop besteht aus zwei Hauptkomponenten: HDFS (Hadoop Distributed File System) für die Speicherung und MapReduce für die Verarbeitung. Beispiel: Um Daten mit Hadoop zu analysieren, können Sie MapReduce-Jobs in Java schreiben oder Tools wie Hive oder Pig verwenden. Hier ist ein einfaches Beispiel für einen MapReduce-Job, der die Häufigkeit jedes Wortes in einer Textdatei zählt:

- Kibana: Kibana ist ein kostenloses Tool, das mit Elasticsearch kompatibel ist. Es ermöglicht Benutzern, ihre Daten durch interaktive Dashboards zu visualisieren. Benutzer können Diagramme, Karten und Tabellen erstellen und Daten in Echtzeit filtern.

- PostgreSQL: Ein leistungsstarkes, Open-Source relationales Datenbankmanagmentssystem, das fortschrittliche Datenanalysemöglichkeiten unterstützt, wie Fensterfunktionen und rekursive Abfragen. PostgreSQL hat einen Ruf für Zuverlässigkeit, Leistung und Erweiterbarkeit. Beispiel:

public class WordCount {

public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "word count");

job.setJarByClass(WordCount.class);

job.setMapperClass(TokenizerMapper.class);

job.setCombinerClass(IntSumReducer.class);

job.setReducerClass(IntSumReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}Dieser Java-Code definiert einen MapReduce-Job, der die Häufigkeit jedes Wortes in einer Textdatei zählt. Der Mapper tokenisiert den Eingabetext und gibt (word, 1)-Paare aus, während der Reducer die Zählungen für jedes Wort summiert.

Um ein Dashboard in Kibana zu erstellen, gehen Sie zuerst auf die Registerkarte “Dashboard”. Klicken Sie dann auf “Neues Dashboard erstellen”. Fügen Sie schließlich Visualisierungen hinzu, indem Sie auf “Hinzufügen” klicken. Sie können das Dashboard anpassen und für die zukünftige Verwendung speichern.

SELECT product_id, SUM(quantity) AS total_quantity, SUM(price * quantity) AS total_revenue FROM sales GROUP BY product_id ORDER BY total_revenue DESC LIMIT 10;

Diese SQL-Abfrage berechnet die Gesamtmenge und den Umsatz für jedes Produkt. Sie ordnet dann die Ergebnisse nach Umsatz und zeigt die Top-10-Produkte an.

Datenanalyseprozess

Diese Open-Source-Lösungen bieten Organisationen flexible, skalierbare und kosteneffiziente Optionen zur Analyse ihrer umfangreichen Datensätze. Durch die Nutzung dieser Tools können Unternehmen wertvolle Einblicke gewinnen, ohne teure kommerzielle Lizenzen zu benötigen.

Vorteile der Nutzung von Datenanalyse-Tools

Investitionen in Datenanalyse-Tools bieten Organisationen zahlreiche Vorteile, einschließlich:

- Verbesserte Entscheidungsfindung: Diese Tools helfen Organisationen, bessere Entscheidungen zu treffen, indem sie Einblicke basierend auf Daten liefern.

- Erhöhte Effizienz: Datenanalyse-Tools automatisieren und rationalisieren Datenverarbeitungs- und Analysetätigkeiten, wodurch Zeit und Ressourcen gespart werden.

- Erhöhtes Kundenverständnis: Die Analyse von Kundendaten hilft Organisationen, ihre Zielgruppe besser zu verstehen und effektivere Marketing- und Personalisierungsstrategien zu entwickeln.

- Wettbewerbsvorteil: Durch die Nutzung von Datenanalyse-Tools können Organisationen Trends, Chancen und Risiken vor ihren Wettbewerbern erkennen, was ihnen einen strategischen Vorteil bietet.

- Kosteneinsparungen: Durch die Optimierung von Abläufen, die Reduzierung von Verschwendung und die Identifizierung von Verbesserungsmöglichkeiten können Datenanalyse-Tools Organisationen helfen, Kosten zu senken und die Rentabilität zu steigern.

Da die Datenmengen zunehmen, wird der Einsatz von Analyse-Tools für Organisationen immer wichtiger, um in einer datengesteuerten Welt wettbewerbsfähig zu bleiben.

Auswahl des richtigen Datenanalyse-Tools

Die Auswahl des richtigen Datenanalyse-Tools für Ihre Organisation kann aufgrund der vielen verfügbaren Optionen schwierig sein. Berücksichtigen Sie bei der Bewertung der verschiedenen Optionen die folgenden Faktoren:

- Skalierbarkeit: Kann das Tool das Volumen, die Geschwindigkeit und die Vielfalt Ihrer Daten bewältigen? Stellen Sie sicher, dass die gewählte Lösung skalierbar ist, um Ihren aktuellen und zukünftigen Bedarf zu decken.

- Benutzerfreundlichkeit: Ist das Tool benutzerfreundlich und zugänglich für technische und nicht-technische Benutzer? Berücksichtigen Sie die Lernkurve und ob das Tool intuitive Schnittstellen und Visualisierungen bietet.

- Integration: Integriert sich das Tool in Ihre bestehenden Datenquellen und -systeme? Stellen Sie sicher, dass die Lösung nahtlos in Ihre Dateninfrastruktur und Arbeitsabläufe eingebunden werden kann.

- Kosten: Wie hoch sind die Gesamtbetriebskosten, einschließlich Lizenzierung, Hardware und Wartung? Berücksichtigen Sie sowohl die Investitionskosten als auch die laufenden Kosten, wenn Sie verschiedene Optionen bewerten.

- Community und Support: Gibt es eine aktive Community und zuverlässigen Support für das Tool? Eine starke Benutzercommunity und reaktionsschneller Support können sehr wertvoll sein, wenn ein Datenanalysetool implementiert und verwendet wird.

Um das beste Datenanalyse-Tool für Ihre Organisation zu finden, bewerten Sie Ihre Bedürfnisse und vergleichen Sie verschiedene Optionen. Dies wird Ihnen helfen, das Potenzial Ihrer Daten voll auszuschöpfen.

Fazit

Datenanalyse-Tools sind unerlässlich für Organisationen, die die Macht von Big Data nutzen möchten. Durch die Nutzung dieser Tools können Unternehmen wertvolle Erkenntnisse gewinnen, datengestützte Entscheidungen treffen und ihre Gesamtleistung verbessern.

Wenn Sie Ihre Reise der Datenanalyse beginnen, ist es wichtig, Ihre Ziele zu verstehen. Sie sollten auch die verschiedenen verfügbaren Optionen in Betracht ziehen. Während Sie mehr Wissen erlangen, seien Sie bereit, Ihren Ansatz entsprechend anzupassen. Durch dies können Sie Ihre Daten vollständig nutzen und dem Erfolg Ihrer Organisation zum Erfolg verhelfen.