Auditoría de IA Generativa

En el panorama en rápida evolución de la inteligencia artificial, la IA generativa se ha convertido en un pilar de la innovación. Desde ChatGPT de OpenAI hasta Bedrock de Amazon y otras plataformas emergentes, estas tecnologías están reformando cómo interactuamos con las máquinas. Sin embargo, esta revolución trae consigo importantes preocupaciones de privacidad, especialmente en lo que respecta al manejo de Información Personalmente Identificable (PII).

Este artículo analiza los efectos más amplios de las auditorías de IA generativa. Discute los posibles riesgos de privacidad y las formas de mejorar la auditoría y la seguridad.

El Mundo en Expansión de la Auditoría de IA Generativa

La IA generativa ha trascendido más allá de una sola plataforma. Hoy en día, vemos un ecosistema diverso:

- ChatGPT de OpenAI: Una IA conversacional que se ha convertido en sinónimo de capacidades generativas.

- Amazon Bedrock: Un servicio gestionado que permite la fácil integración de modelos fundamentales en aplicaciones.

- Bard de Google: Un servicio experimental de IA conversacional impulsado por LaMDA.

- Servicio Azure OpenAI de Microsoft: Brinda acceso a los modelos de OpenAI con la seguridad y características empresariales adicionales de Azure.

Estas plataformas proporcionan acceso a API para desarrolladores e interfaces basadas en la web para usuarios. Esto aumenta significativamente el riesgo de violaciones de datos.

Riesgos de Privacidad en el Panorama de la IA Generativa

La adopción generalizada de la IA generativa introduce varias preocupaciones de privacidad:

- Retención de Datos: Los modelos de IA pueden almacenar entradas para su mejora, incluyendo potencialmente información sensible.

- Divulgación Involuntaria de Información: Los usuarios podrían revelar accidentalmente PII durante las interacciones.

- Explotación del Modelo: Ataques sofisticados podrían potencialmente extraer datos de entrenamiento de los modelos.

- Agregación de Datos Entre Plataformas: El uso de múltiples servicios de IA podría llevar a la creación de perfiles de usuario exhaustivos.

- Vulnerabilidades de API: Implementaciones inseguras de API podrían exponer datos de usuarios.

Estrategias Generales para Mitigar los Riesgos de Privacidad

Para abordar estas preocupaciones, las organizaciones deben considerar los siguientes enfoques:

- Minimización de Datos: Limitar la cantidad de datos personales procesados por los sistemas de IA.

- Anonimización y Seudonimización: Transformar los datos para eliminar u oscurecer información identificable.

- Encriptación: Implementar una fuerte encriptación para los datos en tránsito y en reposo.

- Controles de Acceso: Gestionar estrictamente quién puede acceder a los sistemas de IA y a los datos almacenados.

- Auditorías de Seguridad Regulares: Realizar revisiones exhaustivas de los sistemas de IA y sus prácticas de manejo de datos.

- Educación del Usuario: Informar a los usuarios sobre los riesgos y las mejores prácticas al interactuar con la IA.

- Marcos de Cumplimiento: Alinear el uso de la IA con regulaciones como GDPR, CCPA y estándares específicos de la industria.

Auditoría de Interacciones de IA Generativa: Aspectos Clave

La auditoría efectiva es crucial para mantener la seguridad y el cumplimiento. Los aspectos clave incluyen:

- Registro Exhaustivo: Grabar todas las interacciones, incluyendo entradas de usuarios y respuestas de la IA.

- Monitoreo en Tiempo Real: Implementar sistemas para detectar y alertar sobre posibles violaciones de privacidad de inmediato.

- Análisis de Patrones: Utilizar aprendizaje automático para identificar patrones de uso inusuales que puedan indicar un mal uso.

- Revisiones Periódicas: Examinar regularmente los registros y patrones de uso para garantizar el cumplimiento y identificar posibles riesgos.

- Auditorías de Terceros: Involucrar a expertos externos para proporcionar evaluaciones imparciales de su uso de IA y medidas de seguridad.

DataSunrise: Una Solución Integral para la Auditoría de IA

DataSunrise ofrece una solución robusta para auditar interacciones de IA generativa en diversas plataformas. Nuestro sistema se integra perfectamente con diferentes servicios de IA, proporcionando un enfoque unificado para la seguridad y el cumplimiento.

Componentes Clave de la Solución de Auditoría de IA de DataSunrise:

- Servicio Proxy: Intercepta y analiza el tráfico entre los usuarios y las plataformas de IA.

- Descubrimiento de Datos: Identifica y clasifica automáticamente la información sensible en interacciones de IA.

- Monitoreo en Tiempo Real: Proporciona alertas inmediatas sobre posibles violaciones de privacidad.

- Registro de Auditoría: Crea registros detallados e inalterables de todas las interacciones de IA.

- Informes de Cumplimiento: Genera informes adaptados a varios requisitos normativos.

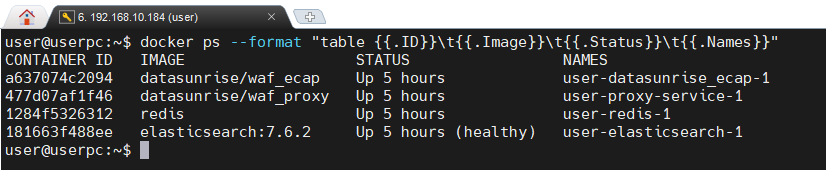

La imagen de abajo muestra cuatro contenedores Docker en ejecución. Estos contenedores proporcionan la funcionalidad de Firewall de Aplicación Web de DataSunrise, mejorando la seguridad del sistema representado.

Configuración de Ejemplo con DataSunrise

Una implementación típica de DataSunrise para auditoría de IA podría incluir:

- DataSunrise Proxy: Desplegado como un proxy inverso frente a los servicios de IA.

- Redis: Para almacenamiento en caché y gestión de sesiones, mejorando el rendimiento.

- Elasticsearch: Para un almacenamiento y recuperación eficientes de los registros de auditoría.

- Kibana: Para visualizar datos de auditoría y crear paneles personalizados.

- Consola de Gestión de DataSunrise: Para configurar políticas y ver informes.

Esta configuración puede desplegarse fácilmente utilizando herramientas de orquestación de contenedores como Docker y Kubernetes, asegurando escalabilidad y facilidad de gestión.

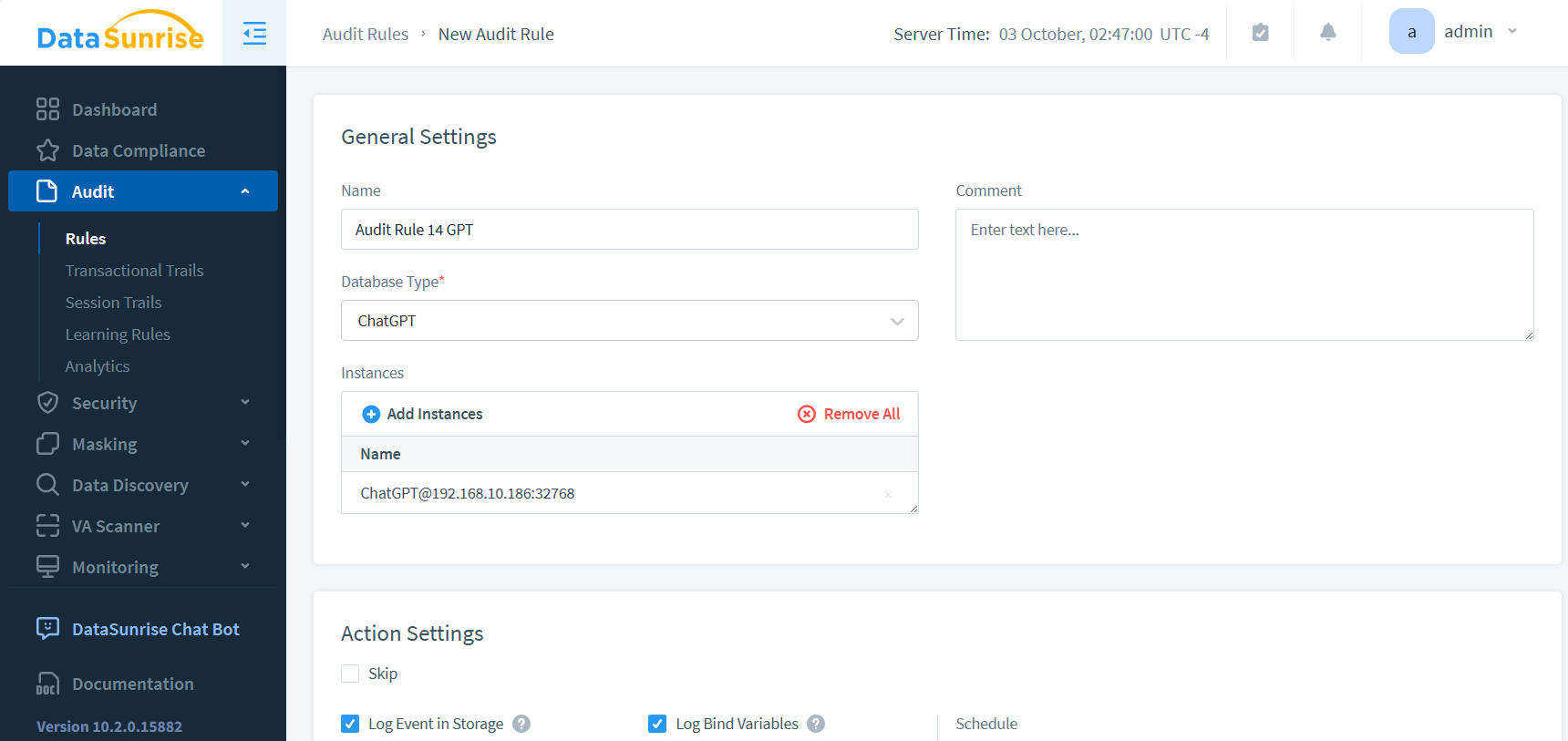

La configuración de reglas de auditoría es sencilla. En este caso, seleccionamos la instancia relevante, que no es una base de datos sino ChatGPT, una aplicación web. Este proceso demuestra la flexibilidad del sistema de auditoría para manejar varios tipos de aplicaciones.

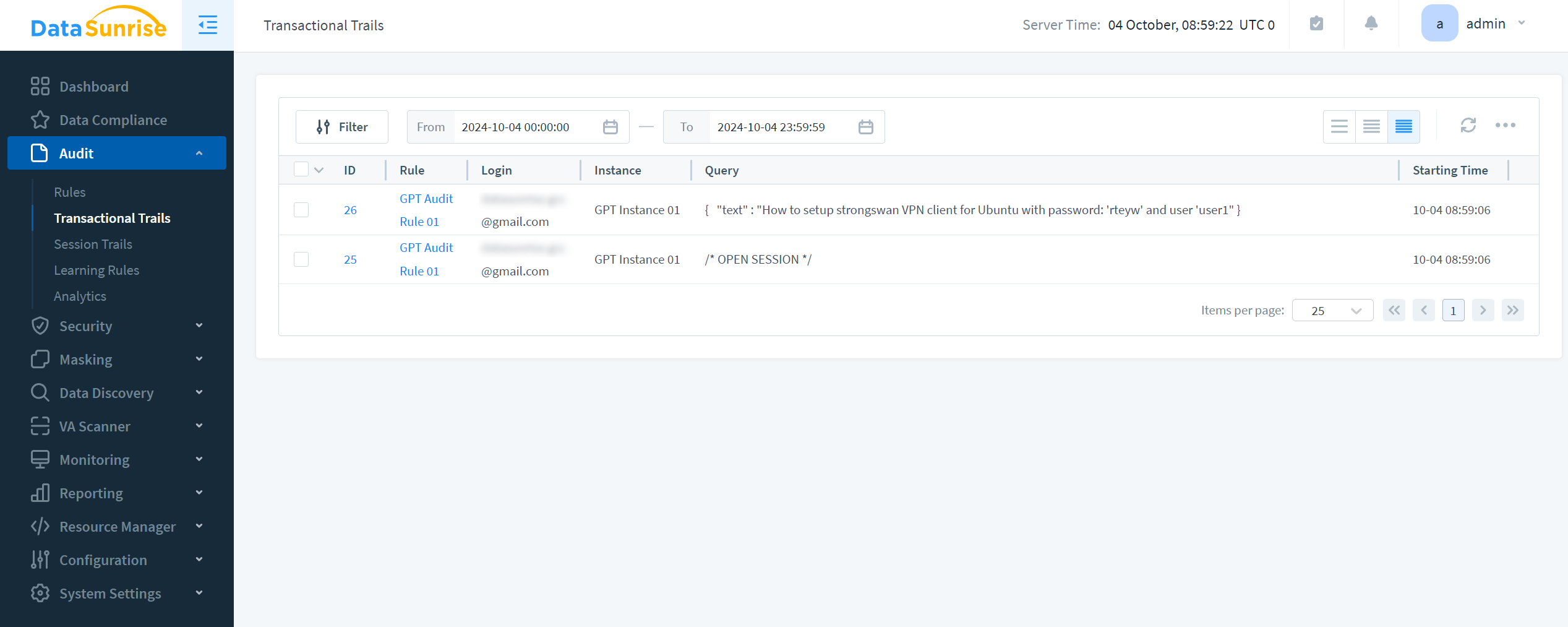

Los resultados de la auditoría y la solicitud de GPT correspondiente son los siguientes:

Conclusión: Adoptando IA con Confianza

La IA generativa se está convirtiendo en parte de nuestras vidas diarias y negocios. A medida que evoluciona, necesitamos medidas de auditoría y seguridad sólidas. Estas medidas son esenciales para la seguridad.

Al usar estrategias claras y herramientas avanzadas de DataSunrise, las organizaciones pueden usar la IA de manera efectiva. También pueden mantener los datos seguros y proteger la privacidad.

El futuro de la IA es brillante, pero debe construirse sobre una base de confianza y seguridad. Al usar medidas adecuadas de auditoría y privacidad, podemos desbloquear completamente el potencial de la IA generativa. Esto ayudará a proteger los derechos y la información tanto de los individuos como de las organizaciones.

DataSunrise: Su Socio en Seguridad de IA

DataSunrise lidera en seguridad de IA. Proporciona no solo herramientas de auditoría sino también un conjunto completo de funcionalidades. Estas herramientas protegen sus datos en diferentes plataformas y bases de datos.

Nuestra solución se ajusta a los desafíos específicos de la IA generativa. Esto ayuda a su organización a mantenerse por delante de las posibles amenazas.

Lo invitamos a explorar cómo DataSunrise puede mejorar su postura de seguridad de IA. Visite el sitio web de DataSunrise para programar una demostración. Aprenda cómo nuestras soluciones avanzadas pueden ayudarlo a gestionar la gobernanza de IA y la protección de datos.