Audit de l’IA Générative

Dans le paysage en rapide évolution de l’intelligence artificielle, l’IA générative est devenue un pilier de l’innovation. De ChatGPT d’OpenAI à Bedrock d’Amazon en passant par d’autres plateformes émergentes, ces technologies redéfinissent notre interaction avec les machines. Cependant, cette révolution entraîne des préoccupations importantes en matière de confidentialité, en particulier concernant le traitement des informations personnellement identifiables (PII).

Cet article examine les effets plus larges des audits de l’IA générative. Il discute des risques potentiels pour la confidentialité et des moyens d’améliorer l’audit et la sécurité.

Le Monde Élargi de l’Audit de l’IA Générative

L’IA générative a transcendé une seule plateforme. Aujourd’hui, nous voyons un écosystème diversifié :

- ChatGPT d’OpenAI : Une IA conversationnelle devenue synonyme de capacités génératives.

- Amazon Bedrock : Un service entièrement géré permettant une intégration facile des modèles de base dans les applications.

- Bard de Google : Un service expérimental d’IA conversationnelle alimenté par LaMDA.

- Service Azure OpenAI de Microsoft : Fournit un accès aux modèles d’OpenAI avec les caractéristiques supplémentaires de sécurité et d’entreprise d’Azure.

Ces plateformes fournissent un accès API pour les développeurs et des interfaces Web pour les utilisateurs. Cela augmente considérablement le risque de violations de données.

Risques de Confidentialité dans le Paysage de l’IA Générative

L’adoption généralisée de l’IA générative introduit plusieurs préoccupations en matière de confidentialité :

- Rétention des Données : Les modèles d’IA peuvent stocker des entrées pour s’améliorer, potentiellement y compris des informations sensibles.

- Divulgation Involontaire d’Informations : Les utilisateurs peuvent accidentellement révéler des PII pendant les interactions.

- Exploitation des Modèles : Des attaques sophistiquées pourraient potentiellement extraire des données d’entraînement des modèles.

- Agrégation de Données Multi-Plateformes : Utiliser plusieurs services d’IA pourrait conduire à des profils utilisateurs complets.

- Vulnérabilités de l’API : Des implémentations d’API non sécurisées pourraient exposer des données utilisateur.

Stratégies Générales pour Atténuer les Risques de Confidentialité

Pour répondre à ces préoccupations, les organisations devraient envisager les approches suivantes :

- Minimisation des Données : Limiter la quantité de données personnelles traitées par les systèmes d’IA.

- Anonymisation et Pseudonymisation : Transformer les données pour supprimer ou obscurcir les informations identifiantes.

- Cryptage : Mettre en œuvre un cryptage robuste pour les données en transit et au repos.

- Contrôles d’Accès : Gérer strictement qui peut accéder aux systèmes d’IA et aux données stockées.

- Audits de Sécurité Réguliers : Conduire des examens approfondis des systèmes d’IA et de leurs pratiques de gestion des données.

- Formation des Utilisateurs : Informer les utilisateurs sur les risques et les meilleures pratiques lors des interactions avec l’IA.

- Cadres de Conformité : Aligner l’utilisation de l’IA avec des réglementations comme le RGPD, CCPA, et des normes spécifiques à l’industrie.

Audit des Interactions d’IA Générative : Aspects Clés

Un audit efficace est crucial pour maintenir la sécurité et la conformité. Les aspects clés incluent :

- Journalisation Complète : Enregistrer toutes les interactions, y compris les entrées utilisateur et les réponses de l’IA.

- Surveillance en Temps Réel : Mettre en œuvre des systèmes pour détecter et alerter immédiatement sur des violations potentielles de confidentialité.

- Analyse de Modèles : Utiliser l’apprentissage automatique pour identifier des modèles d’utilisation inhabituels pouvant indiquer un usage abusif.

- Revues Périodiques : Examiner régulièrement les journaux et les modèles d’utilisation pour s’assurer de la conformité et identifier des risques potentiels.

- Audits par des Tiers : Faire appel à des experts externes pour fournir des évaluations impartiales de votre utilisation de l’IA et des mesures de sécurité.

DataSunrise : Une Solution Complète pour l’Audit de l’IA

DataSunrise offre une solution robuste pour l’audit des interactions d’IA générative sur différentes plateformes. Notre système s’intègre parfaitement avec divers services d’IA, fournissant une approche unifiée de sécurité et de conformité.

Composants Clés de la Solution d’Audit de l’IA de DataSunrise :

- Service Proxy : Intercepte et analyse le trafic entre les utilisateurs et les plateformes d’IA.

- Découverte des Données : Identifie et classe automatiquement les informations sensibles dans les interactions d’IA.

- Surveillance en Temps Réel : Fournit des alertes immédiates en cas de violations potentielles de confidentialité.

- Journalisation des Audits : Crée des journaux détaillés et infalsifiables de toutes les interactions d’IA.

- Rapports de Conformité : Génère des rapports adaptés à diverses exigences réglementaires.

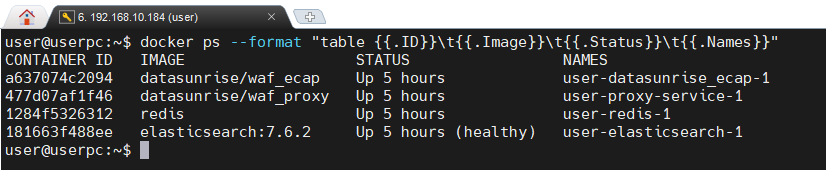

L’image ci-dessous montre quatre conteneurs Docker en cours d’exécution. Ces conteneurs fournissent les fonctionnalités de pare-feu d’application Web de DataSunrise, augmentant la sécurité du système représenté.

Configuration Exemple avec DataSunrise

Un déploiement typique de DataSunrise pour l’audit de l’IA pourrait inclure :

- Proxy DataSunrise : Déployé en tant que proxy inversé devant les services d’IA.

- Redis : Pour la mise en cache et la gestion des sessions, améliorant les performances.

- Elasticsearch : Pour le stockage et la récupération efficaces des journaux d’audit.

- Kibana : Pour visualiser les données d’audit et créer des tableaux de bord personnalisés.

- Console de Gestion DataSunrise : Pour configurer les politiques et visualiser les rapports.

Cette configuration peut être facilement déployée en utilisant des outils d’orchestration de conteneurs comme Docker et Kubernetes, assurant évolutivité et facilité de gestion.

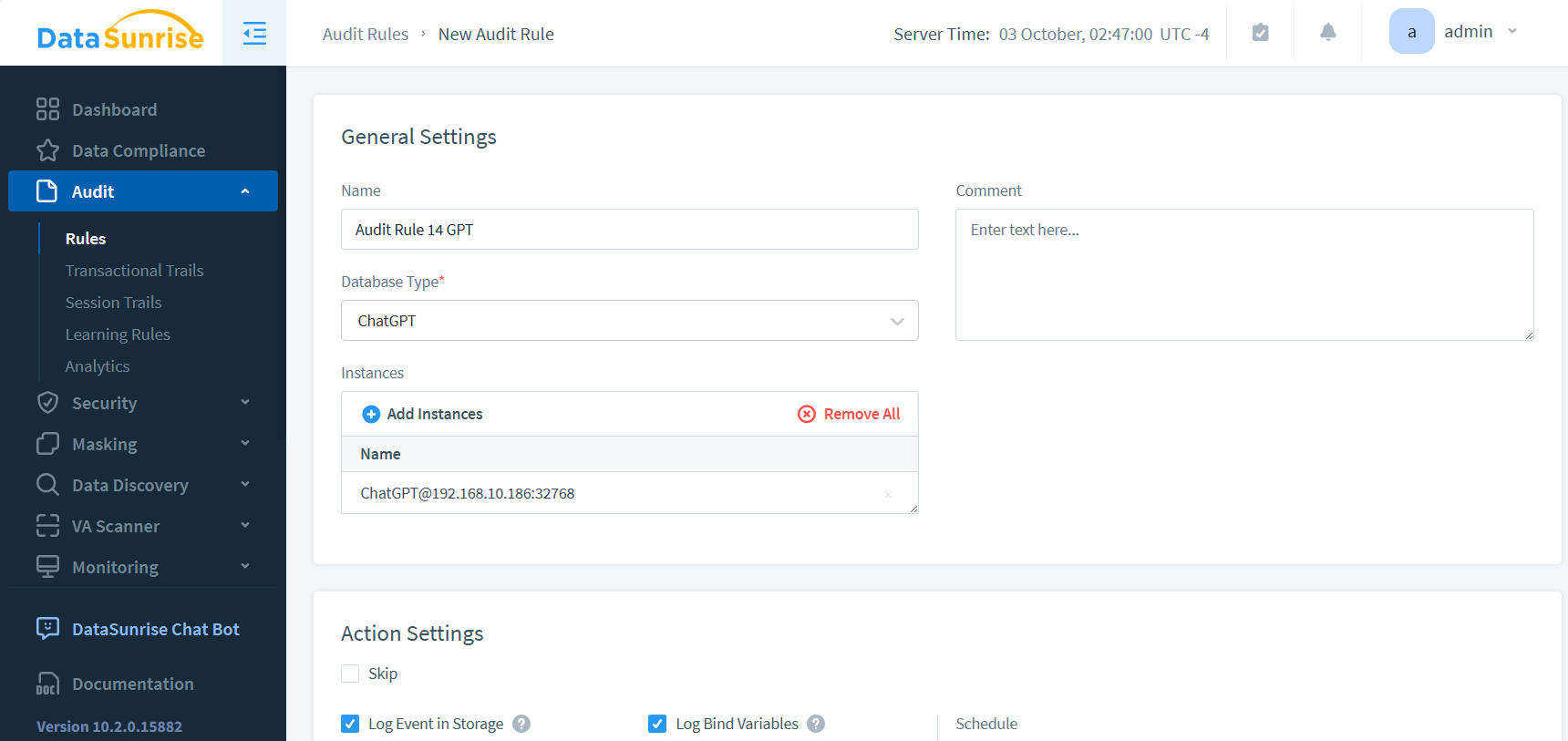

Configurer les règles d’audit est simple. Dans ce cas, nous sélectionnons l’instance pertinente, qui n’est pas une base de données mais plutôt ChatGPT, une application Web. Ce processus démontre la flexibilité du système d’audit pour gérer divers types d’applications.

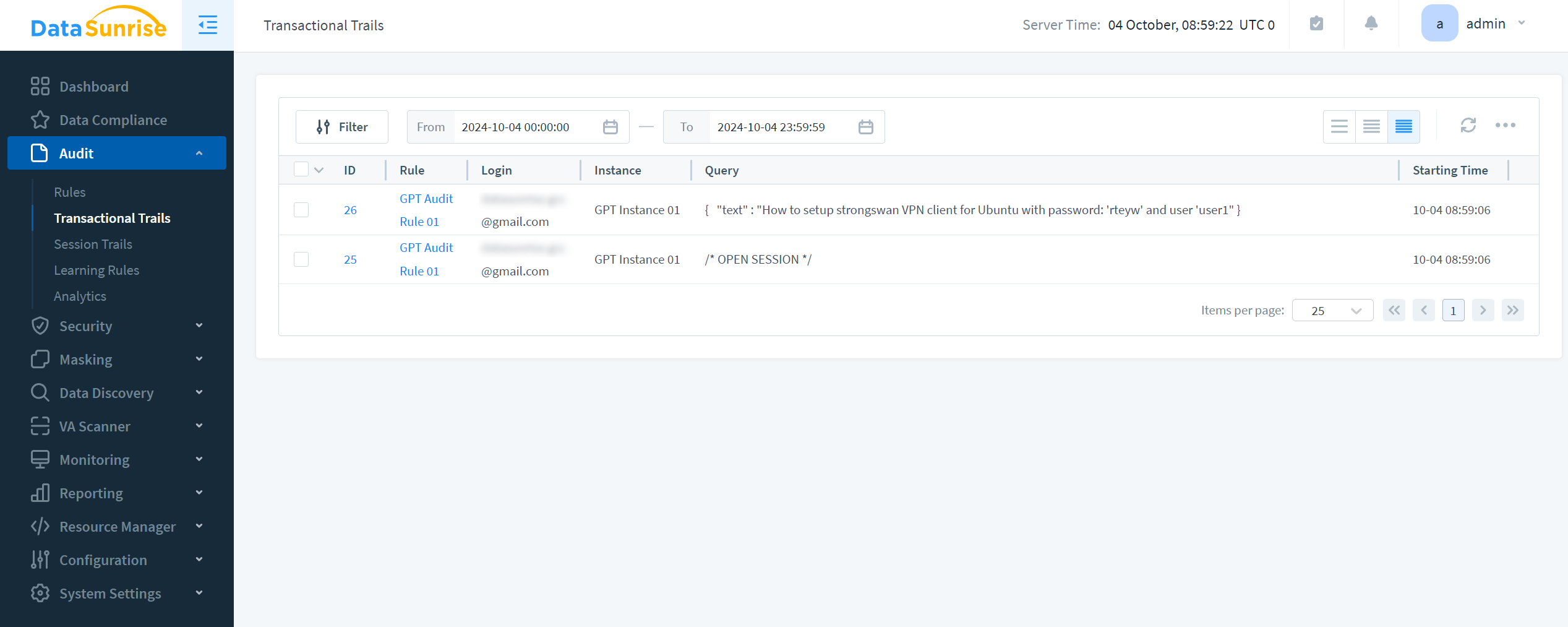

Les résultats de l’audit et l’invite GPT correspondante sont les suivants :

Conclusion : Utiliser l’IA en Toute Confiance

L’IA générative fait partie de notre quotidien et de nos activités commerciales. À mesure qu’elle évolue, nous avons besoin de mesures d’audit et de sécurité solides. Ces mesures sont essentielles pour la sécurité.

En utilisant des stratégies claires et des outils avancés de DataSunrise, les organisations peuvent utiliser l’IA efficacement. Elles peuvent également garantir la sécurité des données et protéger la confidentialité.

Le futur de l’IA est prometteur, mais il doit être construit sur une base de confiance et de sécurité. En utilisant des mesures d’audit et de confidentialité appropriées, nous pouvons pleinement libérer le potentiel de l’IA générative. Cela contribuera à protéger les droits et les informations des individus et des organisations.

DataSunrise : Votre Partenaire en Sécurité de l’IA

DataSunrise est un leader en sécurité de l’IA. Il fournit non seulement des outils d’audit mais aussi un ensemble complet de fonctionnalités. Ces outils protègent vos données sur différentes plateformes et bases de données.

Notre solution s’adapte aux défis spécifiques de l’IA générative. Cela aide votre organisation à rester en avance sur les menaces potentielles.

Nous vous invitons à découvrir comment DataSunrise peut améliorer votre posture de sécurité de l’IA. Visitez le site Web de DataSunrise pour planifier une démo. Découvrez comment nos solutions avancées peuvent vous aider à gérer la gouvernance de l’IA et la protection des données.