Journal d’Audit Hive

Introduction

Avec le recours croissant des organisations à Apache Hive pour gérer et analyser de grandes quantités de données structurées, il devient crucial d’assurer la sécurité des données, la conformité et la transparence opérationnelle. Mettre en place un journal d’audit Hive efficace aide les organisations à suivre les activités des utilisateurs, à identifier les accès non autorisés et à respecter les exigences réglementaires de conformité telles que le RGPD, la HIPAA et le SOC 2.

Comprendre le Journal d’Audit Hive

Un journal d’audit Hive est un enregistrement complet des événements survenant au sein de l’environnement Hive, y compris les requêtes des utilisateurs, les modifications de données, les tentatives d’accès et les opérations au niveau du système. Ces journaux peuvent fournir des informations précieuses sur la manière dont les données sont accessibles et manipulées, offrant une base pour la sécurité, la conformité et l’optimisation des performances.

Capacités de Suivi du Journal d’Audit Hive Natif

Apache Hive utilise trois mécanismes de journalisation principaux pour suivre les activités du système : les journaux d’audit HDFS pour les opérations au niveau des fichiers, les journaux HiveServer2 pour les détails d’exécution des requêtes, et les journaux du Metastore pour les modifications de métadonnées. Chaque type répond à des besoins d’audit distincts tout en se complétant pour fournir une surveillance complète du système :

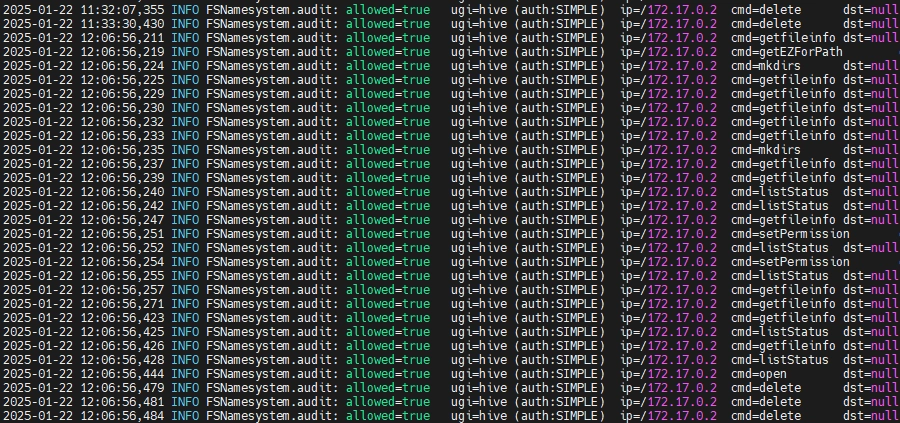

Journaux d’Audit HDFS dans le Journal d’Audit Hive

Étant donné que Hive repose sur HDFS pour le stockage de données, les journaux d’audit HDFS jouent un rôle crucial dans le suivi des opérations au niveau des fichiers, renforçant les efforts de sécurité et de conformité.

Accéder aux Journaux

Les journaux d’audit HDFS sont généralement stockés à :

/var/log/hadoop/hdfs/hdfs-audit.log

Commandes courantes pour analyser les journaux d’audit :

# Voir tout le journal

cat /var/log/hadoop/hdfs/hdfs-audit.log

# Rechercher des opérations spécifiques

grep "cmd=open" /var/log/hadoop/hdfs/hdfs-audit.log

# Supprimer le champ 'src' et filtrer pour 'hive' pour une meilleure lisibilité

sed -E 's/\bsrc=[^[:space:]]+[[:space:]]*//g' /var/log/hadoop/hdfs/hdfs-audit.log | grep "hive"

Format de Journal

Chaque entrée de journal d’audit contient des détails structurés dans le format suivant :

timestamp INFO FSNamesystem.audit : allowed=<true/false> ugi=<user> ip=<client_ip> cmd=<operation> src=<path> dst=<path> perm=<permissions> proto=<protocol> callerContext=<context>

Informations Clés de l’Audit

Les journaux d’audit HDFS fournissent des informations telles que :

- Suivi des opérations en utilisant les champs

HIVE_QUERY_IDetHIVE_SSN_ID. - Surveillance des actions au niveau des fichiers (ex. : création, suppression, modifications de permissions).

- Journalisation des activités basées sur l’utilisateur au sein de l’écosystème Hadoop.

Dans l’ensemble, les journaux d’audit HDFS sont principalement conçus pour le dépannage du système de fichiers et la surveillance opérationnelle. Bien qu’ils fournissent des informations sur les opérations et les modèles d’accès aux fichiers, leur utilité pour un audit de sécurité complet est limitée.

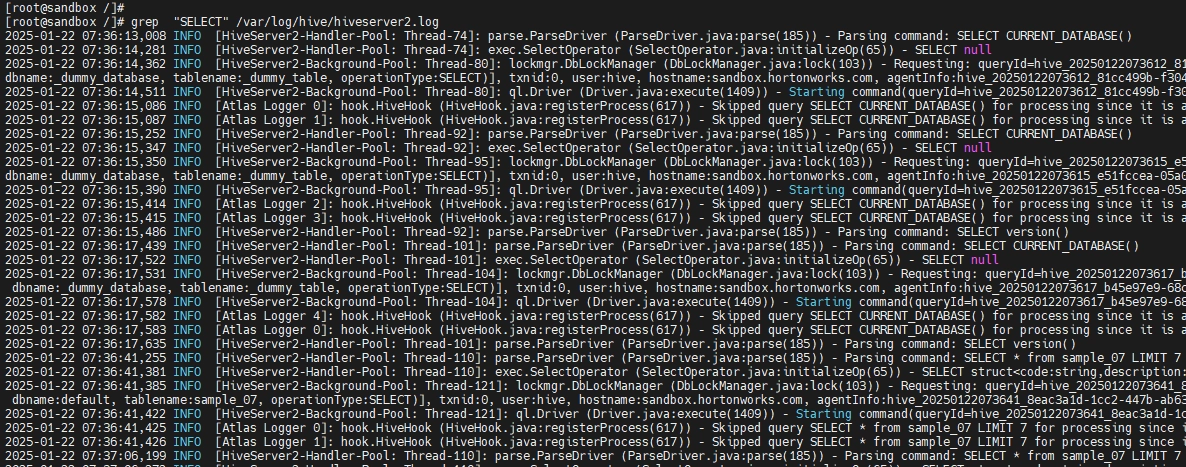

Journaux HiveServer2

Les journaux HiveServer2 capturent les opérations au niveau des requêtes et les informations de session utilisateur, fournissant des informations sur les opérations SQL et les performances des requêtes.

Accéder aux Journaux

Emplacement par défaut dans la plupart des installations :

/var/log/hive/hiveserver2.log

Commandes courantes pour l’analyse des journaux :

# Voir tout le journal

cat /var/log/hive/hiveserver2.log

# Rechercher des requêtes spécifiques

grep "QUERY:" /var/log/hive/hiveserver2.log

# Formater la sortie pour une meilleure lisibilité

awk '{printf "%-23s %-15s %-10s %-50s\n", $1" "$2, $5, $7, $9}' /var/log/hive/hiveserver2.log`

Format de Journal

Les journaux HiveServer2 contiennent des informations détaillées sur l’exécution des requêtes :

timestamp INFO [SessionState] - Query: <SQL_query> Status: <status> QueryID: <query_id>

Informations Clés de l’Audit

Les journaux HiveServer2 fournissent des informations précieuses sur :

- Texte complet des requêtes SQL et plans d’exécution

- Statut et durée de l’exécution des requêtes

- Gestion des sessions utilisateur et authentification

- Allocation et utilisation des ressources

- Messages d’erreur et échecs de requêtes

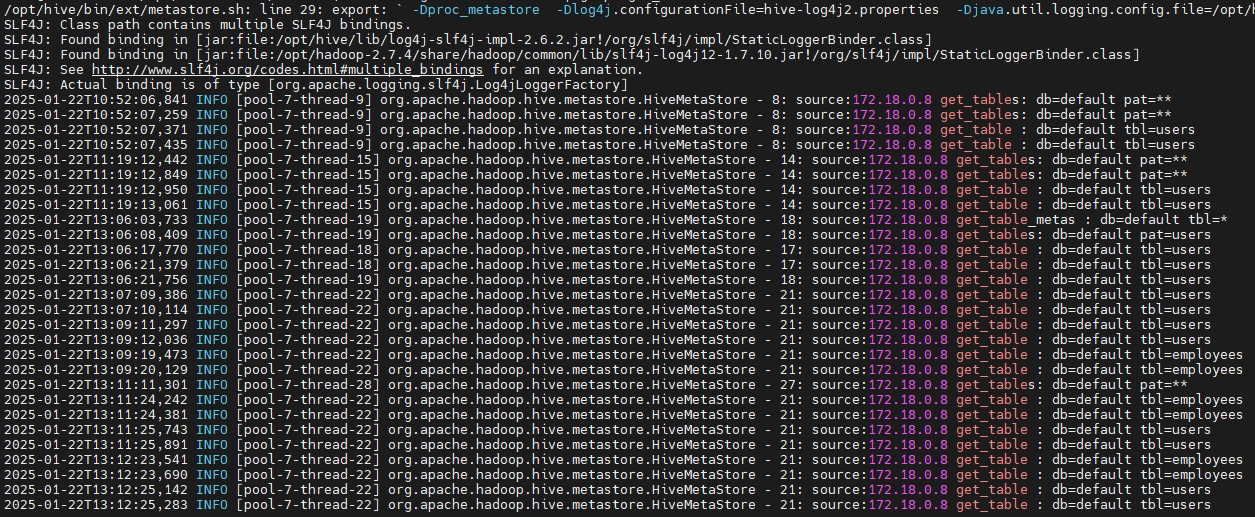

Journaux d’Audit du Metastore

Les journaux d’audit du Hive Metastore capturent les opérations de métadonnées telles que la création, la suppression et les modifications de schéma des tables.

Accéder aux Journaux

Les journaux d’audit se trouvent généralement à :

/var/log/hive/hive-audit.log

Commandes courantes pour analyser les journaux Metastore :

# Voir tout le journal

cat /var/log/hive/hive-audit.log

# Suivre les mises à jour du journal en temps réel

tail -f /var/log/hive/hive-audit.log

# Filtrer les journaux par opération spécifique

grep "get_table" /var/log/hive/hive-audit.log

Format de Journal

Chaque entrée suit généralement ce format :

timestamp INFO [thread-info] org.apache.hadoop.hive.metastore.HiveMetaStore - <event-id>: source=<client_ip> <operation>: db=<database> tbl=<table> newtbl=<new_table>

Informations Clés de l’Audit

- Capture des opérations DDL comme

CREATE,ALTER, etDROP. - Fournit des informations sur les modifications de schéma et l’activité des utilisateurs.

- Utile pour suivre les changements de métadonnées à travers les bases de données.

Utiliser ces journaux de manière efficace nécessite une planification minutieuse et peut souvent exiger des solutions de sécurité et de surveillance supplémentaires ou des intégrations avec des plateformes spécialisées axées sur la conformité et la sécurité comme DataSunrise pour établir un cadre d’audit plus complet.

Pour plus d’informations sur la journalisation de Hive, vous pouvez consulter la documentation officielle Apache Hive.

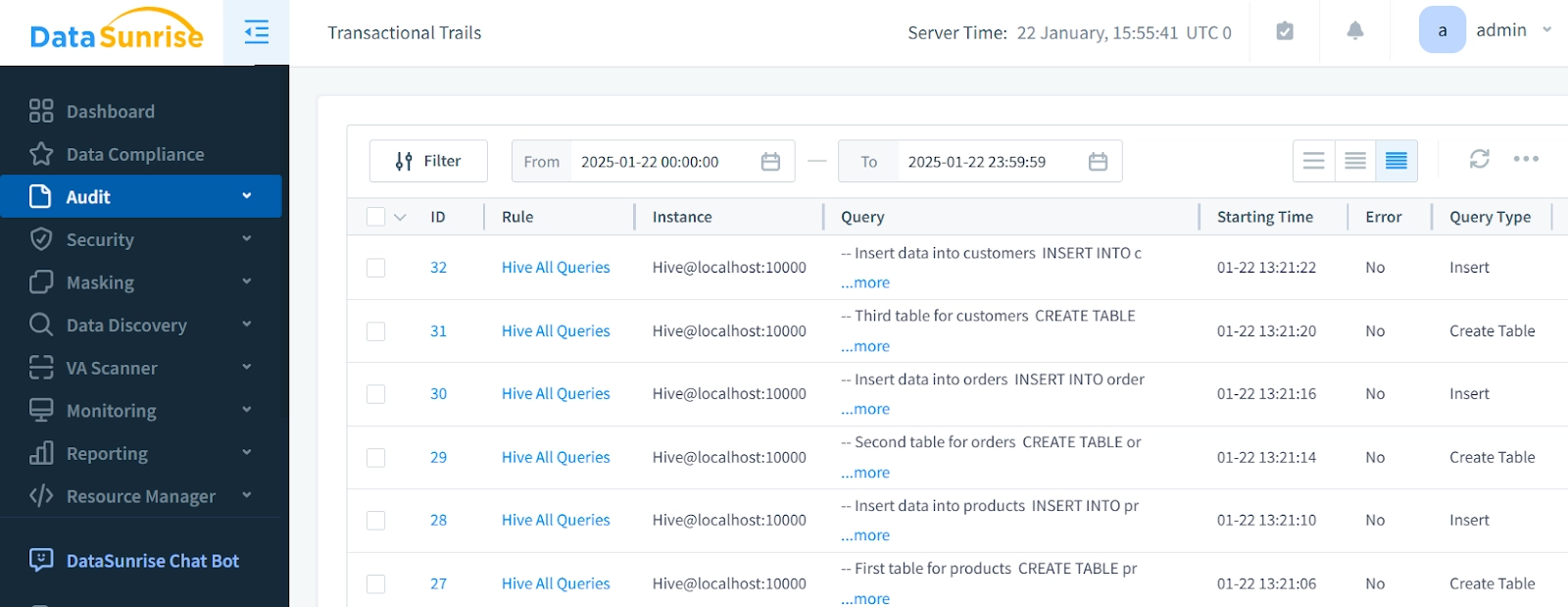

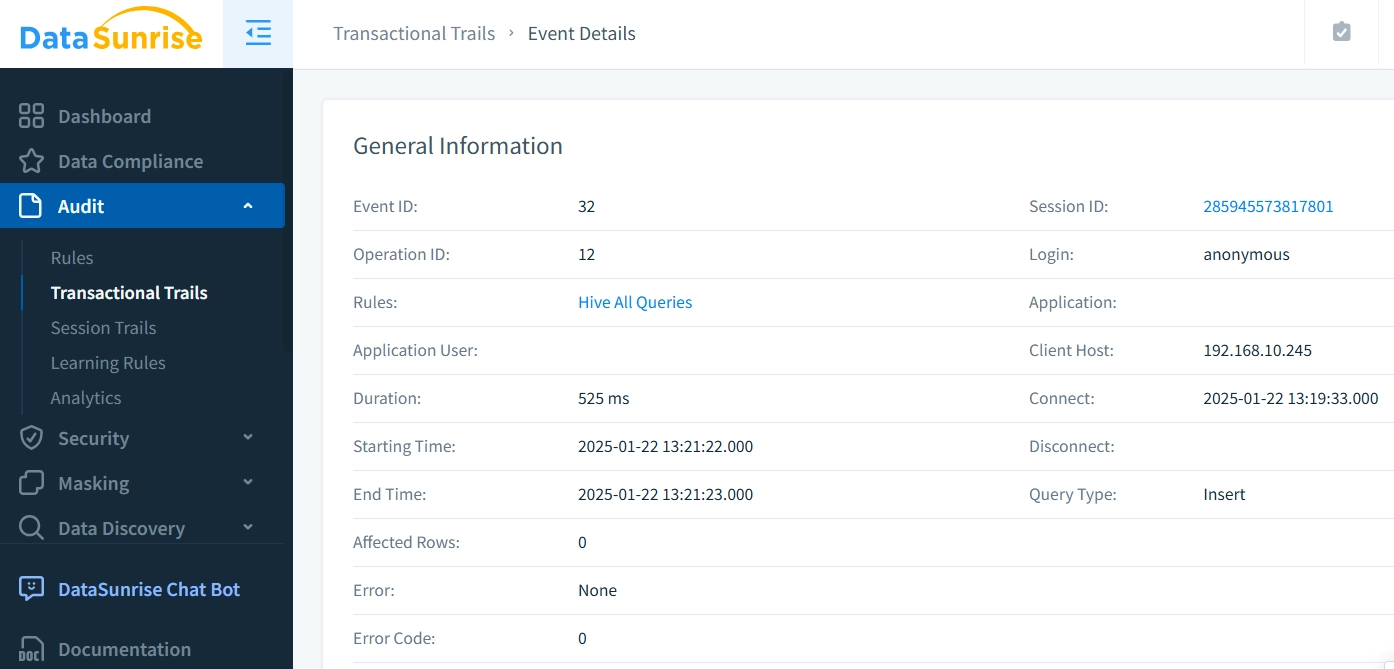

Journal d’Audit Hive dans DataSunrise

DataSunrise simplifie l’audit Hive en consolidant les journaux de plusieurs sources en un seul, journal d’audit complet. Contrairement aux solutions natives qui produisent des données à fort volume et peu de contexte, DataSunrise capture des événements d’audit critiques avec un contexte détaillé. Son intégration de proxy inversé transforme les journaux bruts de Hive en journaux d’audit exploitables, soutenant les exigences de sécurité, de conformité et opérationnelles tout en assurant un stockage efficace et un impact minimal sur les performances.

Principales Caractéristiques de DataSunrise pour le Journal d’Audit Hive

- Informations contextuelles riches sur les requêtes SQL, y compris l’identité de l’utilisateur, les détails des requêtes et les modèles d’accès

- Suivi détaillé des séances avec des données complètes d’authentification et d’autorisation

- Stockage efficace avec filtrage intelligent des événements et compression

- Visibilité et reporting améliorés pour les journaux d’audit et la conformité de sécurité

- Impact minimal sur les performances des opérations Hive avec filtrage intelligent des événements

- Capture des événements d’audit en temps réel sans surcharge d’analyse de journaux

- Pas de modifications à l’infrastructure Hive existante

Avantages Supplémentaires

En plus de sa fonctionnalité d’audit étendue, DataSunrise offre également une suite d’outils puissants conçus pour améliorer la sécurité, la surveillance et l’analyse pour Hive et plusieurs autres environnements pris en charge. Les principaux avantages incluent :

- Rapport de Conformité Automatisé: Générez automatiquement des rapports de conformité détaillés pour le RGPD, la HIPAA et d’autres réglementations.

- Notifications en Temps Réel: Recevez des alertes instantanées pour les événements critiques afin de faciliter une réponse immédiate.

- Analyse du Comportement: Identifiez des modèles inhabituels et des menaces potentielles avec des analyses avancées.

- Outils LLM et ML: Exploitez l’apprentissage machine et les grands modèles de langage pour renforcer la sécurité et améliorer les capacités de surveillance.

Conclusion : Renforcer le Suivi de Votre Journal d’Audit Hive

En résumé, la mise en œuvre d’un journal d’audit Hive robuste est cruciale pour maintenir la sécurité des données, assurer la conformité réglementaire et améliorer la transparence opérationnelle. Bien que le journal d’audit natif de Hive fournisse un niveau de suivi de base, les organisations à la recherche de capacités d’audit plus avancées peuvent grandement bénéficier d’outils comme DataSunrise.

DataSunrise ne se contente pas d’améliorer les fonctionnalités natives de Hive mais propose également une surveillance en temps réel, une gestion centralisée des journaux, un masquage dynamique des données et des outils de reporting automatisés, offrant une solution plus sophistiquée pour la protection des données et les journaux d’audit.

Si vous souhaitez améliorer votre environnement Hive avec des fonctionnalités d’audit avancées, planifiez une démo dès aujourd’hui et élevez vos efforts de sécurité des données et de conformité au niveau supérieur.