Che Cos’è il Dato Dinamico?

Nel frenetico mondo digitale di oggi, che produce 5 exabyte di dati ogni giorno, i dati sono il lifeblood delle aziende e delle organizzazioni. Ma non tutti i dati sono creati eguali.

Alcuni dati rimangono costanti, mentre altri cambiano rapidamente. Queste informazioni in continua evoluzione sono ciò che chiamiamo dati dinamici. In questo articolo, ci immergeremo nel mondo dei dati in costante cambiamento, esplorandone la natura, i tipi e le sfide che presentano nella gestione dei dati.

La Natura del Dato Dinamico

Questo tipo di dati è un’informazione che cambia frequentemente, spesso in tempo reale. A differenza dei dati statici, che rimangono costanti nel tempo, è fluido e reattivo a fattori esterni. Questa caratteristica lo rende sia prezioso che difficile da gestire.

Perché Questi Dati Sono Importanti

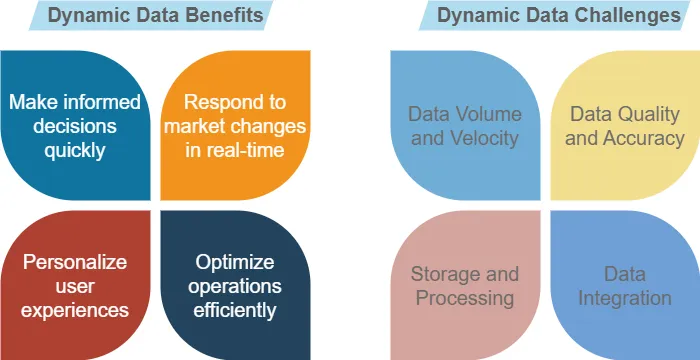

In un’era in cui l’informazione è potere, i dati ricevuti just in time forniscono approfondimenti aggiornati al minuto. Permette alle aziende di beneficiare, ma anche di affrontare alcune sfide. Vedi alcune di queste nella figura sottostante.

Ad esempio, un’app meteo si basa su dati dinamici per fornire previsioni accurate. Man mano che le condizioni cambiano, così anche i dati, assicurando che gli utenti abbiano sempre le informazioni più aggiornate.

Tipi di Dati Dinamici

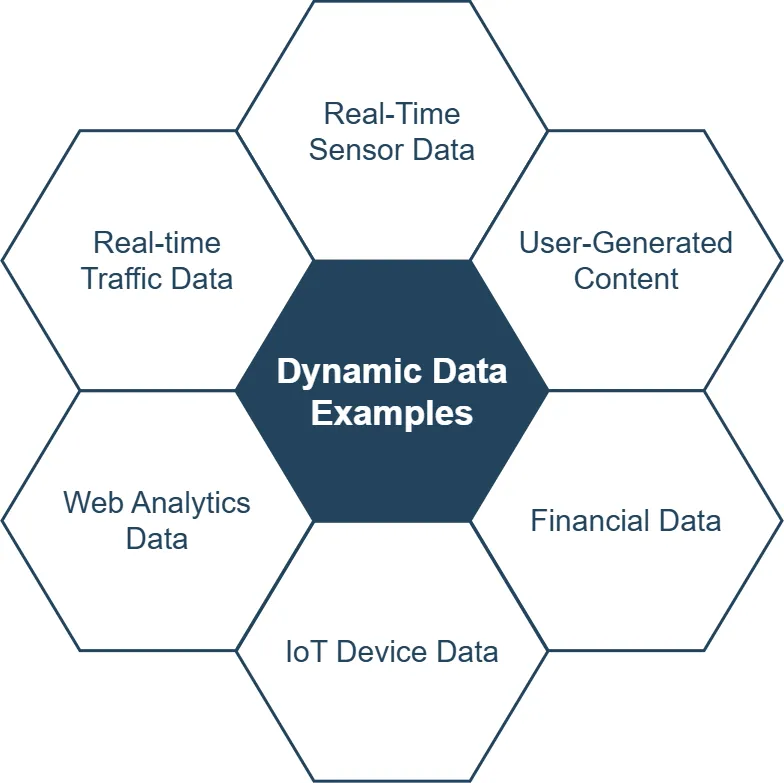

Si presenta in varie forme, ciascuna con le proprie caratteristiche e applicazioni. Esploriamo alcuni tipi comuni:

1. Dati di Sensori in Tempo Reale

I sensori raccolgono continuamente dati dal mondo fisico. Questo include:

- Letture di temperatura

- Livelli di umidità

- Rilevazione di movimento

- Coordinate GPS

Ad esempio, i dispositivi domestici intelligenti utilizzano i dati dei sensori per regolare automaticamente i sistemi di riscaldamento e raffreddamento.

2. Contenuti Generati dagli Utenti

Le piattaforme di social media sono un esempio principale di dati dinamici in azione. Gli utenti creano costantemente nuovi post, commenti e reazioni, generando un flusso continuo di contenuti dinamici.

3. Dati Finanziari

I prezzi delle azioni, i tassi di cambio e i valori delle criptovalute fluttuano costantemente. Le istituzioni finanziarie si affidano a questi dati dinamici per decisioni di trading e investimento.

4. Dati dei Dispositivi IoT

L’Internet of Things (IoT) genera continuamente enormi quantità di dati. I dispositivi connessi trasmettono continuamente informazioni sul loro stato, utilizzo e ambiente.

5. Dati di Analisi Web

Siti web e applicazioni raccolgono dati in tempo reale sul comportamento degli utenti, tra cui:

- Visualizzazioni di pagina

- Percentuali di clic

- Durata della sessione

- Percentuali di conversione

Questo tipo di dati aiuta le aziende a ottimizzare la loro presenza online e le strategie di marketing.

Sfide nella Gestione dei Dati Instabili

Sebbene questo tipo di dati offra numerosi vantaggi, presenta anche sfide uniche per i processi di gestione dei dati.

1. Volume e Velocità dei Dati

L’enorme quantità di dati generati può essere opprimente. La raccolta dei dati in questo caso è complessa. Le organizzazioni devono disporre di sistemi robusti per gestire flussi di dati ad alta velocità.

2. Qualità e Accuratezza dei Dati

Con dati che cambiano rapidamente, garantire l’accuratezza diventa più difficile. Informazioni obsolete o errate possono portare a decisioni sbagliate. Cerca sempre di migliorare la qualità dei dati prima di raccogliere approfondimenti.

3. Memorizzazione ed Elaborazione

In questo caso, i dati richiedono soluzioni di memorizzazione flessibili e capacità di elaborazione efficienti per gestire aggiornamenti e query in tempo reale.

4. Integrazione dei Dati

Combinare dati dinamici da più fonti può essere complesso. Garantire la coerenza e la coesione tra i diversi flussi di dati è cruciale.

5. Sicurezza e Privacy

Proteggere i dati dinamici presenta sfide uniche per la sicurezza. Man mano che i dati cambiano rapidamente, mantenere controlli di accesso adeguati e crittografia diventa più complesso.

Elaborazione Ottimale dei Dati per Dati che Cambiano

Per sfruttare il potere dei dati che cambiano costantemente, le organizzazioni devono implementare strategie di elaborazione dei dati ottimali.

I metodi tradizionali di batch processing spesso non sono sufficienti quando si tratta di struttura di dati che cambia. Le tecniche di elaborazione in tempo reale, come lo stream processing, consentono un’analisi immediata dei dati e un’azione rapida.

Esempio:

from pyspark.streaming import StreamingContext

# Crea uno StreamingContext con un intervallo di batch di 1 secondo

ssc = StreamingContext(sc, 1)

# Crea un DStream che si collega a una fonte di dati

lines = ssc.socketTextStream("localhost", 9999)

# Elabora il flusso

word_counts = lines.flatMap(lambda line: line.split(" ")) \

.map(lambda word: (word, 1)) \

.reduceByKey(lambda a, b: a + b)

# Stampa i risultati

word_counts.pprint()

# Avvia il calcolo

ssc.start()

ssc.awaitTermination()Questo codice PySpark dimostra l’elaborazione in tempo reale di un flusso di testo, contando le parole man mano che arrivano.

Spiegazione del Codice

Il codice di PySpark Streaming fornito sopra fa quanto segue:

- Prima di tutto, importa lo StreamingContext dal modulo streaming di PySpark.

- Crea uno StreamingContext (ssc) con un intervallo di batch di 1 secondo. Questo significa che il calcolo dello streaming sarà diviso in batch da 1 secondo.

- Imposta un DStream (Discretized Stream) che si collega a una fonte di dati. In questo caso, sta leggendo da un socket in localhost alla porta 9999. Questo potrebbe essere qualsiasi fonte di dati in streaming.

- Il codice poi elabora il flusso:

- Divide ogni riga in parole

- Map each word to a key-value pair (word, 1)

- Riduce per chiave, contando efficacemente le occorrenze di ogni parola

- Stampa i risultati del conteggio delle parole.

- Infine, avvia il calcolo e attende la sua terminazione.

Questo codice crea essenzialmente un sistema di conteggio delle parole in tempo reale. Continuerebbe a leggere dati di testo dal socket specificato, contare le parole in tempo reale (aggiornando ogni secondo) e stampare i risultati.

È un esempio semplice ma potente di come PySpark Streaming possa essere utilizzato per l’elaborazione di dati in tempo reale. In uno scenario reale, si potrebbe sostituire la fonte del socket con uno stream di dati più robusto (come Kafka) e fare elaborazioni più complesse o memorizzare i risultati in un database invece di stamparli.

Infrastruttura Scalabile

Per gestire il volume e la velocità dei dati dinamici, è essenziale un’infrastruttura scalabile. Le soluzioni basate sul Cloud e i sistemi distribuiti offrono la flessibilità necessaria per adattarsi ai carichi di dati in evoluzione.

Monitoraggio della Qualità dei Dati

Implementare controlli automatizzati della qualità dei dati aiuta a mantenere l’accuratezza e l’affidabilità dei dati dinamici. Questo include:

- Validazione dei formati dei dati

- Verifica degli outlier

- Assicurazione della completezza dei dati

Sicurezza dei Dati Dinamici: Proteggere le Informazioni Fluide

Proteggere questi dati richiede un approccio proattivo e adattivo. Ecco alcune strategie chiave:

1. Crittografia Durante il Transito e a Riposo

Assicurati che i dati dinamici siano crittografati sia quando si spostano tra i sistemi sia quando sono memorizzati.

2. Controllo di Accesso in Tempo Reale

Implementa meccanismi di controllo di accesso dinamico che possano adattarsi ai dati e ai contesti utente in cambiamento.

3. Monitoraggio Continuo

Usa strumenti di monitoraggio in tempo reale per rilevare e rispondere alle minacce alla sicurezza mentre emergono.

4. Anonimizzazione dei Dati

Quando si trattano dati dinamici sensibili, considera tecniche di anonimizzazione per proteggere la privacy individuale mantenendo la utilità dei dati.

Esempio:

import pandas as pd

from faker import Faker

# Carica i dati dinamici

df = pd.read_csv('user_data.csv')

# Inizializza Faker

fake = Faker()

# Anonimizza le colonne sensibili

df['name'] = df['name'].apply(lambda x: fake.name())

df['email'] = df['email'].apply(lambda x: fake.email())

# Salva i dati anonimizzati

df.to_csv('anonymized_user_data.csv', index=False)Questo script Python dimostra un semplice processo di anonimizzazione dei dati per dati utente dinamici.

Il Futuro della Data Science

Man mano che la tecnologia continua a evolvere, l’importanza e la prevalenza dei dati dinamici cresceranno solo. Le tendenze emergenti includono:

- Edge Computing: Elaborazione di questi dati più vicina alla loro fonte per ottenere approfondimenti più rapidi

- Analisi Basate sull’Intelligenza Artificiale: Utilizzo del machine learning per estrarre approfondimenti più profondi dai flussi di dati dinamici

- Blockchain per l’Integrità dei Dati: Garantire l’autenticità e la tracciabilità dei dati dinamici

Conclusione: Abbracciare la Rivoluzione dei Dati Dinamici

I dati dinamici stanno trasformando il modo in cui comprendiamo e interagiamo con il mondo che ci circonda. Dai business insights in tempo reale alle esperienze utente personalizzate, il loro impatto è ampio. Sebbene la gestione dei dati dinamici presenti sfide, i benefici superano di gran lunga le difficoltà.

Implementando processi robusti di gestione dei dati, strategie di elaborazione ottimali e misure di sicurezza solide, le organizzazioni possono sfruttare al massimo il potenziale dei dati dinamici. Utilizzare efficacemente i dati dinamici offrirà un grande vantaggio nel nostro mondo guidato dai dati.

Per le aziende che cercano di proteggere e gestire i propri dati in modo efficace, DataSunrise offre strumenti user-friendly e flessibili per la sicurezza e la conformità dei database on-premises e nel Cloud. Visita il nostro sito web su DataSunrise per una demo online e scopri come possiamo aiutarti a proteggere i tuoi preziosi asset di dati.